เรารู้แล้วว่า Large Hadron Collider (LHC) จะเป็นการทดลองทางฟิสิกส์ที่ใหญ่ที่สุดและมีราคาแพงที่สุดที่มนุษย์ดำเนินการ การรวมกันของอนุภาคสัมพัทธภาพที่พลังงานซึ่งไม่สามารถจินตนาการได้ก่อนหน้านี้ (มากถึง 14 TeV Mark ภายในสิ้นทศวรรษ) จะสร้างอนุภาคนับล้าน (รู้จักและยังไม่ถูกค้นพบ) ซึ่งต้องมีการติดตามและโดดเด่นด้วยเครื่องตรวจจับอนุภาคขนาดใหญ่ การทดลองครั้งประวัติศาสตร์นี้จะต้องมีการรวบรวมข้อมูลขนาดใหญ่และความพยายามในการจัดเก็บข้อมูลเขียนกฎของการจัดการข้อมูลอีกครั้ง ทุกห้าวินาทีการชนกันของ LHC จะสร้างมูลค่าเทียบเท่ากับข้อมูล DVD ซึ่งเป็นอัตราการผลิตข้อมูลหนึ่งกิกะไบต์ต่อวินาที คอมพิวเตอร์ทั่วไปที่มีการเชื่อมต่อที่ดีมากอาจสามารถดาวน์โหลดข้อมูลด้วยอัตราหนึ่งหรือสองเมกะไบต์ต่อวินาที (ถ้าคุณโชคดีมากฉันได้รับ 500 กิโลไบต์ / วินาที) ดังนั้นวิศวกร LHC จึงได้ออกแบบวิธีการจัดการข้อมูลรูปแบบใหม่ที่สามารถจัดเก็บและแจกจ่ายได้ เพตาไบต์ (ล้านกิกะไบต์) ข้อมูลไปยังผู้ประสานงาน LHC ทั่วโลก (โดยไม่ต้องล้าสมัยและเป็นสีเทาขณะรอการดาวน์โหลด)

ในปี 1990 องค์การเพื่อการวิจัยนิวเคลียร์แห่งยุโรป (CERN) ได้ปฏิวัติวิธีการที่เราอาศัยอยู่ ปีที่แล้ว Tim Berners-Lee นักฟิสิกส์ CERN เขียนข้อเสนอสำหรับการจัดการข้อมูลอิเล็กทรอนิกส์ เขาหยิบยกแนวคิดที่ว่าสามารถถ่ายโอนข้อมูลได้อย่างง่ายดายผ่านอินเทอร์เน็ตโดยใช้สิ่งที่เรียกว่า "ไฮเปอร์เท็กซ์" เมื่อเวลาผ่านไป Berners-Lee และผู้ร่วมงาน Robert Cailliau วิศวกรระบบที่ CERN ได้รวมเครือข่ายข้อมูลเดียวเข้าด้วยกันเพื่อช่วยให้นักวิทยาศาสตร์ CERN ทำงานร่วมกันและแบ่งปันข้อมูลจากคอมพิวเตอร์ส่วนบุคคลโดยไม่ต้องบันทึกลงในอุปกรณ์จัดเก็บข้อมูลที่ยุ่งยาก ไฮเปอร์เท็กซ์ทำให้ผู้ใช้สามารถเรียกดูและแชร์ข้อความผ่านหน้าเว็บโดยใช้ เชื่อมโยงหลายมิติ. จากนั้น Berners-Lee ก็เริ่มสร้างเบราว์เซอร์ - บรรณาธิการและในไม่ช้าก็ตระหนักว่ารูปแบบการสื่อสารรูปแบบใหม่นี้สามารถแบ่งปันได้โดยผู้คนจำนวนมาก ภายในเดือนพฤษภาคม 1990 นักวิทยาศาสตร์ของ CERN ได้เรียกเครือข่ายความร่วมมือใหม่นี้ว่า เวิลด์ไวด์เว็บ. ในความเป็นจริง CERN รับผิดชอบเว็บไซต์แรกของโลก: http://info.cern.ch/ และตัวอย่างแรก ๆ ของสิ่งที่เว็บไซต์นี้ดูเหมือนว่าสามารถพบได้ผ่านทางเว็บไซต์ของ World Wide Web Consortium

ดังนั้น CERN จึงไม่ใช่คนแปลกหน้าในการจัดการข้อมูลผ่านทางอินเทอร์เน็ต แต่ LHC ใหม่จะต้องได้รับการดูแลเป็นพิเศษ ดังที่ David Bader ผู้อำนวยการบริหารการคำนวณประสิทธิภาพสูงที่ Georgia Institute of Technology ใช้แบนด์วิดท์ปัจจุบันที่อนุญาตโดยอินเทอร์เน็ตเป็นคอขวดขนาดใหญ่ทำให้การแบ่งปันข้อมูลในรูปแบบอื่นเป็นที่ต้องการมากขึ้น “หากฉันดู LHC และสิ่งที่กำลังทำเพื่ออนาคตสิ่งหนึ่งที่เว็บไม่สามารถทำได้คือการจัดการข้อมูลจำนวนมหาศาลที่เป็นปรากฎการณ์เขากล่าวว่าหมายความว่าง่ายกว่าที่จะบันทึกชุดข้อมูลขนาดใหญ่บนฮาร์ดไดรฟ์เทราไบต์และส่งไปยังผู้ทำงานร่วมกันในโพสต์ แม้ว่า CERN ได้ระบุถึงลักษณะการทำงานร่วมกันของการแบ่งปันข้อมูลบนเวิลด์ไวด์เว็บ แต่ข้อมูลที่ LHC จะสร้างขึ้นจะทำให้แบนด์วิดท์ขนาดเล็กที่มีอยู่ในปัจจุบันมีมากเกินไปได้อย่างง่ายดาย

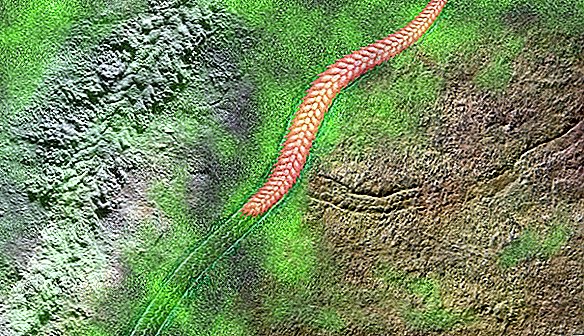

นี่คือเหตุผลที่ LHC Computing Grid ถูกออกแบบ กริดจัดการการผลิตชุดข้อมูล LHC มากมายในระดับแรกชั้นที่ 0) ตั้งอยู่ในสถานที่ที่ CERN ใกล้กับกรุงเจนีวาประเทศสวิตเซอร์แลนด์ Tier 0 ประกอบด้วยเครือข่ายคอมพิวเตอร์คู่ขนานขนาดใหญ่ที่มี CPU ขั้นสูง 100,000 ชุดที่จัดเก็บและจัดการข้อมูลดิบ (รหัสไบนารี 1 และ 0s) โดย LHC เป็นที่น่าสังเกตว่า ณ จุดนี้ว่าเซ็นเซอร์ไม่สามารถตรวจจับการชนกันของอนุภาคทั้งหมดได้เพียงเศษเสี้ยวเล็ก ๆ เท่านั้นที่สามารถจับได้ แม้ว่าจะตรวจพบอนุภาคเพียงเล็กน้อยเท่านั้น แต่ก็ยังสามารถแปลงเป็นเอาต์พุตขนาดใหญ่ได้

Tier 0 จัดการส่วนของข้อมูลที่ส่งออกโดยการระเบิดผ่านสายไฟเบอร์ออปติก 10 กิกะบิตต่อวินาทีโดยเฉพาะเป็น 11 ชั้นที่ 1 ไซต์ในอเมริกาเหนือเอเชียและยุโรป สิ่งนี้ช่วยให้ผู้ทำงานร่วมกันเช่น Relativistic Heavy Ion Collider (RHIC) ที่ห้องปฏิบัติการแห่งชาติ Brookhaven ในนิวยอร์กสามารถวิเคราะห์ข้อมูลจากการทดลอง ALICE เปรียบเทียบผลลัพธ์จากการชนกันของ LHC กับไอออนของผลการชน

จากคอมพิวเตอร์ระหว่างประเทศระดับที่ 1 ชุดข้อมูลจะได้รับการบรรจุและส่งไปยัง 140 ชั้นที่ 2 เครือข่ายคอมพิวเตอร์ตั้งอยู่ที่มหาวิทยาลัยห้องปฏิบัติการและ บริษัท เอกชนทั่วโลก ณ จุดนี้นักวิทยาศาสตร์จะสามารถเข้าถึงชุดข้อมูลเพื่อทำการแปลงจากรหัสไบนารี่ดิบเป็นข้อมูลที่ใช้งานได้เกี่ยวกับพลังงานของอนุภาคและวิถี

ระบบระดับนั้นดีและดี แต่มันจะไม่ทำงานหากไม่มีซอฟต์แวร์ที่มีประสิทธิภาพสูงที่เรียกว่า“ มิดเดิลแวร์” เมื่อพยายามเข้าถึงข้อมูลผู้ใช้อาจต้องการข้อมูลที่กระจายไปทั่วเพตาไบต์ของข้อมูลบนเซิร์ฟเวอร์ที่แตกต่างกันในรูปแบบที่แตกต่างกัน แพลตฟอร์มมิดเดิลแวร์โอเพนซอร์สเรียกว่า Globus จะมีความรับผิดชอบอย่างมากในการรวบรวมข้อมูลที่ต้องการอย่างราบรื่นราวกับว่าข้อมูลนั้นอยู่ในคอมพิวเตอร์ของนักวิจัยแล้ว

เป็นการรวมกันของระบบระดับการเชื่อมต่อที่รวดเร็วและซอฟต์แวร์อันชาญฉลาดที่สามารถขยายได้เกินกว่าโครงการ LHC ในโลกที่ทุกอย่างกลายเป็น "ตามต้องการ" เทคโนโลยีประเภทนี้สามารถสร้างอินเทอร์เน็ตได้ โปร่งใส ถึงผู้ใช้ จะมีการเข้าถึงทุกอย่างทันทีจากข้อมูลที่ผลิตโดยการทดลองทางด้านอื่น ๆ ของโลกไปจนถึงการชมภาพยนตร์ความละเอียดสูงโดยไม่ต้องรอแถบความคืบหน้าการดาวน์โหลด เช่นเดียวกับการประดิษฐ์ HTML ของ Berners-Lee LHC Computing Grid อาจปฏิวัติวิธีที่เราใช้อินเทอร์เน็ต

แหล่งที่มา: วิทยาศาสตร์อเมริกัน, เซิร์น